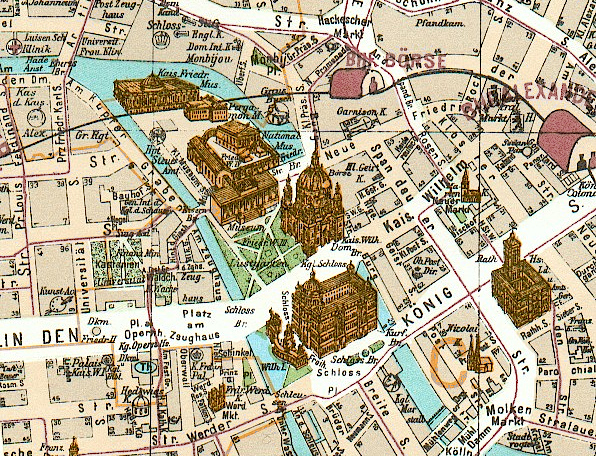

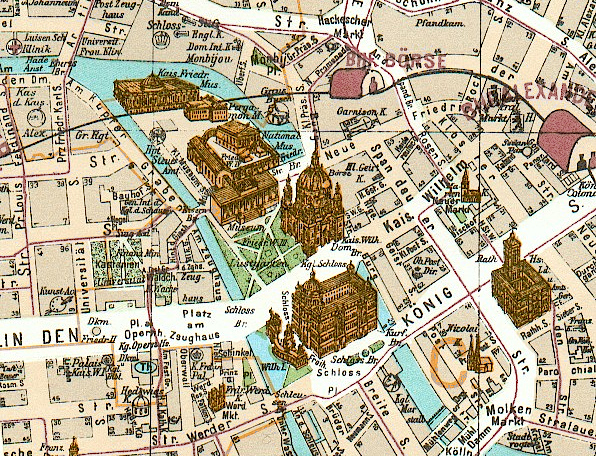

Laut KI: Lippstadt als Kulturstadt? (Symbolbild) |

Laut KI: Lippstadt als Kulturstadt? (Symbolbild) |

Noch offensichtlicher wird es beim Thema Wirtschaft in Lippstadt: Die KI nennt zwei Unternehmen, die laut meiner Websuche tatsächlich in dieser Region existieren, die aber beide weder in Lippstadt ansässig sind noch Zweigstellen hier haben. Hingegen werden tatsächliche Lippstädter Unternehmen gar nicht genannt.

Wie diese Falschinformationen zustande kommen, erkläre ich im folgenden Teil, siehe unten. Die Unwissenheit der KI über das wenig bekannte Lippstadt ist nämlich ein gutes Negativbeispiel.

ChatGPT ist auch in die Kritik geraten, weil Schüler sofort damit anfingen, Hausaufgaben von der KI erledigen zu lassen. An der Hochschule Hamm-Lippstadt (HSHL) wurden Studenten im April 2023 gezielt aufgefordert, eine Hausarbeit mit Hilfe von ChatGPT zu verfassen. Anschließend wurden die damit gemachten Erfahrungen analysiert. Das Presse-Team der HSHL erklärte, dass man den Studierenden die Kompetenzen vermitteln muss, mit der neuen Technik umzugehen und sie gewinnbringend, aber gleichzeitig auch kritisch zu nutzen. Androiden von 1774 © Rama, CC BY-SA 2.0 fr |

Pierre Jaquet-Droz.

Pierre Jaquet-Droz.

Als sich in den 1950ern die Informatik als Wissenschaft etablierte, wurde erstmals 1955 der Begriff „Künstliche Intelligenz“ (KI) bzw. englisch „Artificial Intelligence“ (AI) verwendet.

Im 20. Jahrhundert wurde zunächst „schwache KI“ umgesetzt, d.h. Lösungswege wurden fest einprogrammiert.

Heute würde man das vielleicht eher als Assistenz bezeichnen, nicht als Intelligenz.

Mit dem Ziel zu einer „starken KI“ zu gelangen, versucht man heute einen Ansatz, der mit dem Lernen und der Erziehung eines Kindes vergleichbar ist.

Beim  maschinellen Lernen wird

ein Neuronales Netz so lange mit Trainingsdaten gefüttert, bis es etwas sinnvolles hervorbringt.

Das ist gut mit einem Kleinkind vergleichbar, mit dem man so lange spricht und übt, bis es selber sprechen kann.

Und wenn es Fehler macht, korrigiert man es so lange, bis es weniger Fehler macht.

maschinellen Lernen wird

ein Neuronales Netz so lange mit Trainingsdaten gefüttert, bis es etwas sinnvolles hervorbringt.

Das ist gut mit einem Kleinkind vergleichbar, mit dem man so lange spricht und übt, bis es selber sprechen kann.

Und wenn es Fehler macht, korrigiert man es so lange, bis es weniger Fehler macht.

Seit 2022 kann jeder mit einer KI herumspielen: Die US-Firma OpenAI hat ihre Künstliche Intelligenz ↗„ChatGPT“ am 30.11.2022 als Webseite der Öffentlichkeit frei zugänglich gemacht. Es ist nur eine Anmeldung mit Mail-Adresse und Handy-Nr. erforderlich. Ich habe es im Dezember 2022 ausprobiert und war sofort begeistert, dass die Webseite beliebige Fragen auch auf deutsch versteht und beantwortet. Die "geistige" Flexibilität von ChatGPT zeigt sich darin, dass man sich in Sekundenschnelle z.B. eine Fantasie-Geschichte nach eigenen Vorgaben schreiben lassen kann.

Fragt man die KI nach Informationen zu gut dokumentierten Themen, erhält man beeindruckend gute Antworten. Fragt man jedoch nach Informationen, die nicht oder unzureichend in den Trainingsdaten enthalten waren, plappert die KI irgendetwas, das möglicherweise falsch ist.

Die Frage nach Lippstadt ein gutes Negativbeispiel. Vermutlich war Lippstadt nur mit rudimentären Angaben in den Trainingsdaten enthalten. Die KI weiß einfach noch zu wenig über unser Städtchen. ChatGPT hat absichtlich keinen Zugriff auf das Internet, d.h. die Antwort hängt davon ab, was es aus Trainingsdaten lernen konnte bevor die Frage gestellt wird.

Doch woher kommen die Falschinformationen? ChatGPT ist nicht als Nachschlagewerk konzepiert, sondern ist ein Sprachmodell. Ein Sprachmodell soll geschriebene Sprache verstehen und selber Sätze bilden können. Dies ist die Voraussetzung dafür, dass normale Leute mit der KI interagieren können. Für ChatGPT ist es in erster Linie wichtig, Sätze zu produzieren. Um dieses Ziel zu erreichen, setzt die KI Wörter aneinander, die in einem gegebenen Kontext mit hoher Wahrscheinlichkeit zusammenpassen.

Von Anfang an ist aufgefallen, dass ChatGPT konfabuliert - sich quasi Informationen herbei-halluziniert.

Beim Menschen spricht man von  Konfabulation, wenn

jemand versucht mehr Erinnerungen aus seinem Gedächtnis abzurufen als er sich gemerkt hat.

Das Gehirn füllt die Erinnerungslücken dann mit Sachen, die wahrscheinlich passen. Der Befragte weiß dabei selbst gar nicht, dass es sich nicht um eine echte Erinnerung handelt.

Und das machen wir alle. Jeder hat Lücken, die er automatisch mit kreativen Erklärungen auffüllt.

Konfabulation, wenn

jemand versucht mehr Erinnerungen aus seinem Gedächtnis abzurufen als er sich gemerkt hat.

Das Gehirn füllt die Erinnerungslücken dann mit Sachen, die wahrscheinlich passen. Der Befragte weiß dabei selbst gar nicht, dass es sich nicht um eine echte Erinnerung handelt.

Und das machen wir alle. Jeder hat Lücken, die er automatisch mit kreativen Erklärungen auffüllt.

Wenn man nicht unter Druck steht, kann man einfach locker sagen: „Das weiß ich nicht.“

Wenn man jedoch unter dem Druck steht, jetzt eine Aussage treffen zu müssen, oder wenn man z.B. einen Aufsatz mit einer bestimmten Länge abliefern muss, steigt die Neigung zum Konfabulieren.

Unter dem Druck, die Erwartung zu erfüllen, schwafelt man irgendetwas, das passend klingt - in der Hoffnung, dass es richtig sein könnte (provozierte Konfabulation).

Möglicherweise unterliegt ChatGPT aufgrund irgendwelcher technischer Parameter ebenfalls so einem Beantwortungsdruck.

Da eine KI mit Wahrscheinlichkeiten arbeitet, kann man aus den erfundenen Aussagen über Lippstadt vielleicht ablesen, dass es sehr wahrscheinlich wäre, dass eine Stadt in der Größe von Lippstadt mehreren Museen und Galerien haben könnte und dass es hier mehrere Festivals geben könnte.

Kann man die inhaltlichen Fehler beheben?

Wenn ein Apparat nicht so funktioniert wie man es erwartet, kann man den Mangel in der Mechanik suchen.

Wenn ein herkömmliches Computerprogramm falsche Ergebnisse ausspuckt, kann man den Fehler im Programmcode suchen.

Bei einem Neuronalen Netz ist dies hingegen schwierig, denn das maschinell Gelernte besteht nur aus einer großen Ansammlung von Zahlenwerten,

die nicht direkt aus der Eingabe eines Menschen stammen, sondern vom Neuronalen Netz selbst gespeichert wurden.

Jeder einzelne Zahlenwert hat keine festgelegte Bedeutung, sondern führt nur in Kombination mit unzählen anderen Werten zu einem Ergebnis.

Möchte man ein anderes Ergebnis erhalten, kann man nur die KI solange mit anderen Informationen füttern, bis sie irgendwann das gewünschte Ergebnis liefert.